Warum der Mensch bei KI-Entscheidungen unverzichtbar bleibt

Verfasst von:

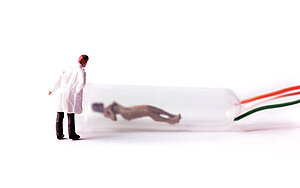

Künstliche Intelligenz trifft blitzschnelle Entscheidungen – doch ohne menschliches Urteilsvermögen bleibt sie fehleranfällig. Warum der Mensch im Entscheidungsprozess unverzichtbar ist und wie „Human in the Loop“-Konzepte Sicherheit, Vertrauen und Verantwortung gewährleisten.

Künstliche Intelligenz (KI) erlebt einen enormen Boom. Spätestens seit der Veröffentlichung von ChatGPT Ende 2022 hat ein regelrechter Hype um KI eingesetzt. Unternehmen experimentieren eifrig mit KI-Systemen und setzen sie in immer mehr Bereichen ein: von automatisierten Übersetzungen und Kundenservices bis hin zur Datenauswertung. Die Fortschritte sind beeindruckend und KI-Outputs übernehmen zunehmend Aufgaben, die einst Menschen vorbehalten waren. Doch so faszinierend die Möglichkeiten auch sind, stellt sich eine entscheidende Frage: Was wird aus dem Menschen in der Schleife (Human in the Loop)? Warum ist es wichtig, dass im Entscheidungsprozess der KI weiterhin ein Mensch das letzte Wort hat?

Warum der Mensch im KI-Entscheidungsprozess eine Schlüsselrolle spielt

KI-Systeme können heute bereits erstaunliche Leistungen erbringen. Sie analysieren riesige Datenmengen in Sekunden, erkennen Muster, die dem Menschen verborgen bleiben, und treffen automatisierte Empfehlungen oder Entscheidungen in vielfältigen Anwendungen. Die Vorteile liegen auf der Hand: Prozesse lassen sich beschleunigen, Kosten sparen und Ergebnisse werden objektiver. Doch trotz aller künstlichen Intelligenz bleibt menschliche Intelligenz unverzichtbar. Es gibt mehrere Gründe, warum der Faktor Mensch in der Schleife der KI-gestützten Entscheidungsfindung entscheidend ist:

Bias und Fehleranfälligkeit:

KI entscheidet auf Basis von Daten und Algorithmen – und diese sind nicht unfehlbar. Selbstlernende Systeme übernehmen oft unbeabsichtigte Vorurteile (sogenannte Bias) aus ihren Trainingsdaten. In der Vergangenheit hatten fehlerhafte KI-Systeme bereits dramatische Folgen: Im „Horizon“-Skandal in Großbritannien beschuldigte eine fehlerhafte Finanzsoftware hunderte Postmitarbeitende fälschlicherweise der Unterschlagung, was zu Verurteilungen führte. In den Niederlanden wurden durch ein automatisiertes Betrugserkennungssystem über 20.000 Eltern fälschlicherweise als Sozialleistungsbetrüger gebrandmarkt und in finanzielle Not gestürzt. Solche Fälle zeigen, wie anfällig vollautomatisierte Prozesse für Fehlentscheidungen sind. Ein Mensch im Kontrollprozess kann hier als Korrektiv dienen, da er Ergebnisse auf Plausibilität prüfen, Daten hinterfragen und eingreifen kann, bevor Schaden entsteht.

Mangelnde Transparenz und Erklärbarkeit:

Viele KI-Modelle, insbesondere komplexe neuronale Netze, funktionieren wie eine sogenannte „Blackbox“. Zwar liefern sie Ergebnisse, doch selbst Fachleute können nicht immer nachvollziehen, wie genau ein bestimmtes Urteil zustande kam. Diese Intransparenz erschwert es Menschen, die Ausgaben der KI zu bewerten. Wie soll ein Mensch effektiv eingreifen oder Verantwortung übernehmen, wenn er die Entscheidungslogik der Maschine nicht versteht? Solange KI-Entscheidungen nicht vollständig nachvollziehbar sind, ist menschliche Urteilsfähigkeit erforderlich, um die Ergebnisse kritisch zu hinterfragen.

Verantwortung und Ethik:

Automatisierte Systeme werfen ethische und rechtliche Verantwortungsfragen auf. Die Verantwortlichkeit verteilt sich dabei auf verschiedene Akteure wie Anbieter, Betreiber, Bevollmächtigte, Einführer und Händler, während die KI selbst juristisch nicht zur Rechenschaft gezogen werden kann.

Letztlich muss der Anwender eines KI-Systems immer eine verantwortliche Person benennen, die den Output dieses Systems prüfen kann. Der Mensch trägt also die letztliche Verantwortung und muss dafür sorgen, dass KI-Ergebnisse verantwortungsvoll genutzt werden. Nur er kann ethische Abwägungen treffen, Empathie zeigen und im Zweifel gegen eine unmenschliche Entscheidung der KI votieren.

Vertrauen und Akzeptanz:

Sowohl die Öffentlichkeit als auch die Mitarbeitenden müssen KI-Systemen vertrauen können, sonst werden sie abgelehnt. Doch Vertrauen entsteht nur durch nachvollziehbare und faire Entscheidungen sowie durch das Gefühl, dass im Hintergrund ein ansprechbarer Mensch steht. Studien zeigen, dass Patienten einem Arzt deutlich mehr vertrauen als einem Computer, denn eine KI kann (noch) kein persönliches Vertrauensverhältnis aufbauen. Dennoch erkennen KI-Systeme beispielsweise Hautkrebs zuverlässiger als Menschen. Ähnliches gilt in anderen Bereichen. Bürger erwarten, dass ein Mensch ihr Anliegen versteht, und Bewerber möchten im Gespräch einen menschlichen Eindruck vom Unternehmen gewinnen. Ein Mensch in der Schleife erhöht somit die Akzeptanz, da er gewährleisten kann, dass individuelle Umstände berücksichtigt und humane Werte gewahrt bleiben.

Dynamik und unvorhergesehene Situationen:

KI-Systeme stoßen in unvorhergesehenen Situationen häufig an ihre Grenzen. Sie sind nur so gut wie die Szenarien, mit denen sie trainiert wurden. Im echten Leben gibt es jedoch immer Ausnahmen und neue Konstellationen. Während ein Mensch flexibel und kreativ reagieren kann, versagen starre Algorithmen. Das zeigt sich beispielsweise bei autonomen Fahrzeugen oder im Kundenservice, wenn KI-Chatbots mit ungewöhnlichen Fragen konfrontiert werden – häufig ist dann eine menschliche Übernahme nötig, um das Problem zu lösen.

Angesichts dieser Faktoren überrascht es nicht, dass Mensch-in-der-Schleife-Konzepte derzeit viel diskutiert und erforscht werden. So untersucht etwa ein Projekt am Alexander-von-Humboldt-Institut, wie die Interaktion zwischen Mensch und Maschine in Entscheidungsprozessen optimal gestaltet werden kann. In verschiedenen Fallstudien (z. B. Kreditvergabe oder Social-Media-Content-Moderation) wird analysiert, welche Faktoren die Entscheidungsqualität verbessern und wie menschliche Eingriffe gestaltet sein müssen, um gute Ergebnisse zu erzielen. Noch ist nicht abschließend geklärt, wie ein wirksamer Human-in-the-Loop aussieht, doch klar ist, dass viele KI-Systeme ohne den Menschen fehlgeleitet würden. Kritisch hierbei ist insbesondere, dass sich der Mensch zu sehr auf die Ausgaben des KI-Systems verlässt und die Ergebnisse nicht kritisch genug nachprüft (übermäßiges Vertrauen in die Automatisierung durch KI).

Fazit: Mensch und KI gemeinsam erfolgreich – Ihr Beitrag ist gefragt!

KI-Output und Mensch-in-der-Schleife – dieses Gespann wird uns in den kommenden Jahren weiter begleiten. Die Stärken der KI (Schnelligkeit, Skalierbarkeit und Mustererkennung) sowie die Stärken des Menschen (Urteilsvermögen, Ethik und Empathie) ergänzen sich hervorragend, sofern sie richtig verzahnt werden. Während rein automatisierte Entscheidungen in trivialen Fällen genügen mögen, benötigen wir bei komplexen oder sensiblen Fragen den Menschen als Entscheider oder zumindest als Supervisor. Unternehmen und Gesellschaft sind gut beraten, KI-Systeme mit eingebauter menschlicher Kontrolle zu entwickeln – nicht als Misstrauensvotum gegen die Technik, sondern als Qualitäts- und Sicherheitsgarantie.

Die Zukunft der KI ist kooperativ: Nicht Mensch oder Maschine, sondern Mensch und Maschine gemeinsam. Indem wir die Rolle des Menschen stärken, stellen wir sicher, dass KI-Systeme unserem Wohl dienen und nicht unbeabsichtigt schaden. Gestalten wir diese Zukunft aktiv mit – zum Nutzen von Unternehmen, Kunden und der gesamten Gesellschaft!

Wir von Althammer & Kill stehen Ihnen bei solchen und anderen Fragen rund um KI, Datenschutz und Informationssicherheit gerne zur Seite. Dabei unterstützt Sie nicht nur ein großes Team, sondern auch hochqualifizierte Mitarbeitende mit weitreichender Erfahrung.

Melden Sie sich für unseren Newsletter an.

Erhalten Sie immer die neuesten und wichtigsten Informationen zum Thema Datenschutz, Informationssicherheit und IT-Sicherheit und Compliance.